S příchodem nových regulací v oblasti bezpilotních letadel se Remote ID (RID) stává důležitým prvkem pro provoz dronů v Evropě. DJI drony certifikované v kategorii C2 jsou povinně vybaveny touto funkcí, která umožňuje vzdálenou identifikaci dronu během letu. V tomto článku se zaměřím na kontrolu správného nastavení a funkčnosti Remote ID pomocí dvou mobilních aplikací – Drone Scan a OpenDroneID.

Co je Remote ID a proč je důležitý?

Remote ID je technologie umožňující sledování dronů v reálném čase. Vysílá informace o dronu, jako jsou:

- Identifikátor dronu (např. číslo sériového čísla nebo unikátní ID)

- Pozice dronu

- Výška letu

- Rychlost a směr

- Pozice řídicí stanice (pilota)

Hlavním cílem této technologie je zvýšit bezpečnost a dohled nad provozem dronů ve vzdušném prostoru, což usnadňuje práci úřadům i ostatním uživatelům vzdušného prostoru.

Nastavení a aktivace Remote ID na DJI dronu

Pokud vlastníte DJI dron kategorie C2, například DJI M4T, je Remote ID integrovanou součástí firmwaru a měl by být aktivní při každém letu. Pro ověření jeho správné funkčnosti postupujte následovně:

- Aktualizujte firmware – Přes aplikaci DJI RC Pilot 2 si ověřte, že máte nainstalovanou nejnovější verzi softwaru.

- Zkontrolujte Remote ID v aplikaci – V aplikaci DJI by měla být možnost zobrazení vysílaných údajů v sekci nastavení dronu.

- Ověřte vysílání Remote ID pomocí externích nástrojů – K tomu jsem otestoval dvě aplikace:

Testování Remote ID pomocí aplikací

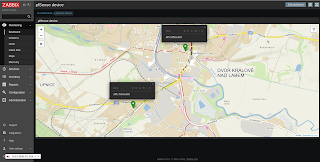

Drone Scan je Android mobilní aplikace umožňující skenování a detekci dronů vysílajících Remote ID signál. Jak probíhalo testování?

- Aplikace rychle zachytila vysílání signálu z DJI M4T.

- Byly správně zobrazeny základní informace jako ID dronu, pozice a výška.

- Výhodou je jednoduchost ovládání a přehledné uživatelské rozhraní.

- Aplikace detekovala dron okamžitě po vzletu.

- Zobrazené informace byly obsáhlejší, včetně údajů o rychlosti a směru letu.

- Možnost podrobného logování letových údajů.

V případě, že aplikace nevidí váš dron, může jít o problém s firmwarem, nesprávným nastavením nebo omezeními v dané oblasti (např. geozóny).

Mé testování proběhlo s Indoor startem v kanceláři. Proto je pozice a jiné údaje nepresně uvedeno. Šlo mi hlavně o identifikator provozovatele. Budu obě aplikace testovat v terénu a věřím že si někde načtu Remote ID i jiného pilota.

Pokud provozujete dron kategorie C2 v souladu s pravidly, správně fungující Remote ID vám pomůže předejít problémům při případných kontrolách a zvýší bezpečnost provozu.

Letu zdar!